Image by ODISSEI, from Unsplash

Quase Metade das Respostas de Pesquisas Online Podem Vir de IA, Descobre Estudo

A pesquisa comportamental online, que antes era vista como um método confiável para estudar a psicologia humana, agora enfrenta um grande problema, pois os participantes usam ferramentas de IA, como chatbots, para gerar suas respostas.

Está com pressa? Aqui estão os fatos rápidos:

- 45% dos participantes da pesquisa Prolific colaram respostas geradas por IA.

- Pesquisadores descobriram que o texto do chatbot geralmente parecia “excessivamente verboso” ou “não humano”.

- Especialistas chamam o problema de “Poluição LLM”, ameaçando a validade da pesquisa comportamental.

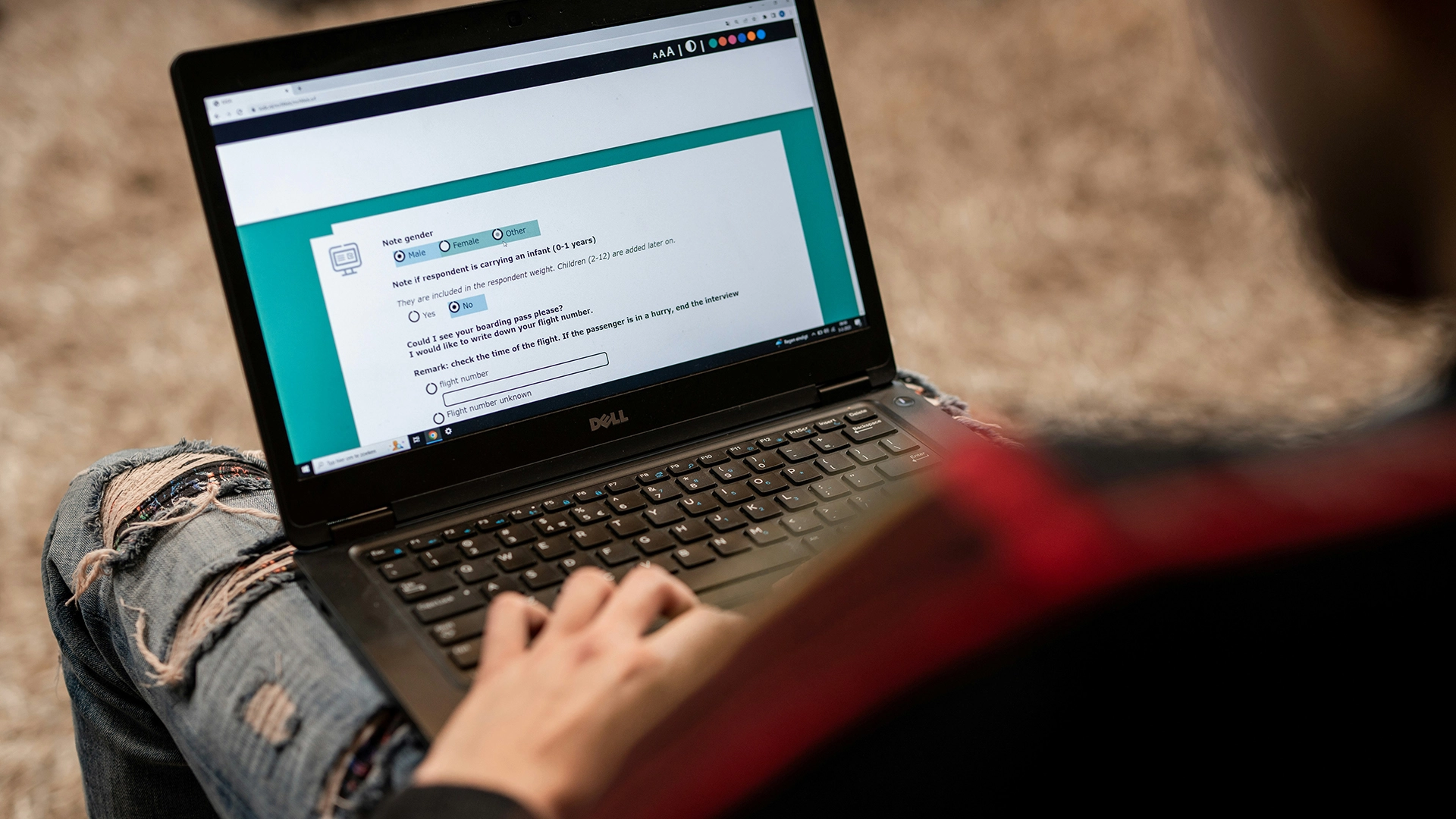

Pesquisadores do Instituto Max Planck para o Desenvolvimento Humano em Berlim recentemente investigaram quão disseminado é o problema em plataformas como a Prolific, que paga voluntários para responderem a pesquisas.

“As taxas de incidência que estávamos observando eram realmente chocantes”, diz a pesquisadora líder Anne-Marie Nussberger, conforme reportado por New Scientist (NS).

Em um teste, 45 por cento dos participantes pareceram colar conteúdo gerado por chatbot em uma caixa de resposta aberta. As respostas frequentemente mostravam sinais como “excessivamente verboso” ou “linguagem distintamente não humana”.

“A partir dos dados que coletamos no início deste ano, parece que uma proporção substancial de estudos está contaminada”, disse Nussberger ao NS.

Para detectar respostas suspeitas, sua equipe introduziu armadilhas ocultas. reCAPTCHAs básicos sinalizaram 0,2 por cento dos usuários, uma versão mais avançada pegou 2,7 por cento, um prompt de texto invisível que pedia a palavra “avelã” capturou 1,6 por cento, e a proibição de copiar e colar revelou mais 4,7 por cento.

O problema evoluiu para o que os especialistas agora chamam de “Poluição LLM”, que vai além da trapaça. O estudo revela três padrões de interferência da IA: Mediação Parcial (IA auxilia com redação ou tradução), Delegação Completa (IA realiza estudos completos) e Transbordamento (os humanos modificam suas ações porque antecipam a presença da IA).

“O que precisamos fazer não é desconfiar totalmente da pesquisa online, mas responder e reagir”, diz Nussberger, pedindo às plataformas que levem o problema a sério, conforme relatado pela NS..

Matt Hodgkinson, um consultor de ética em pesquisa, alerta à NS: “A integridade da pesquisa comportamental online já estava sendo questionada […] Os pesquisadores precisam trabalhar coletivamente para descobrir maneiras de verificar remotamente a participação humana ou retornar à abordagem antiga de contato face a face.”

Prolific optou por não comentar para a NS.

História anterior

História anterior

Artigos mais recentes

Artigos mais recentes